Computergestützte Geodynamik

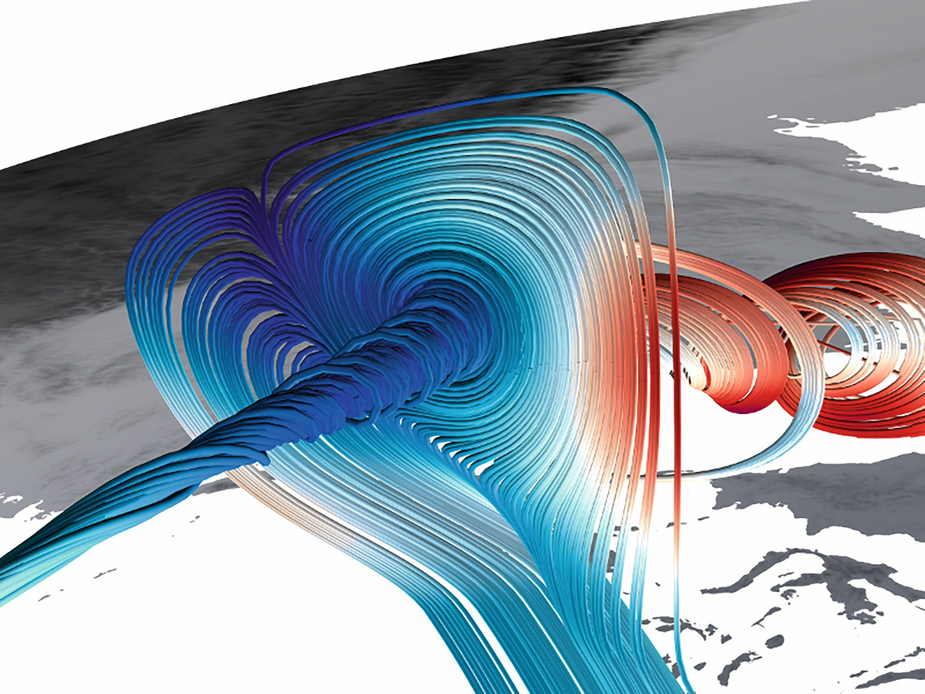

(1) Skalendisparität, d.h. kleine Strukturen müssen in einem globalen konvektiven System aufgelöst werden, (2) 3D-Variationen in Rheologie und Zusammensetzung, (3) komplexe thermodynamische Eigenschaften von Mantelmineralen und (4) die Rückkopplung zwischen dem dynamischen Strömungssystem und seinen Grenzflächen (der Erdoberfläche und der Kern-Mantel-Grenze).

Projekte und High-Performance Computing

Seit ihrem Anfang 2003, war die Münchner Geodynamik-Gruppe aktiv an einer Reihe von HPC- und IT-Projekten beteiligt. Daher besteht eine enge Zusammenarbeit mit der GeoComputing-Gruppe. Die gemeinsame Arbeit umfasst Forschung an stereoskopischer Visualisierung (GeoWall), Datenspeicherung und -verwaltung, sowie numerische und Parallelisierungstechniken, und die Konzeption von Rechenclustern für das "Capacity Computing". Die gegenwärtigen Bemühungen konzentrieren sich auf die Realisierung eines Software-Frameworks für Erdmantelsimulationen im extremen Maßstab. Das Framework ist in der Lage, die Leistung von Exascale-Supercomputern der nächsten Generation (d.h. 1018 Gleitkommaoperationen pro Sekunde werden erreicht) voll auszuschöpfen. Erste spannende Ergebnisse wurden im Projekt TerraNeo erzielt, das vom Schwerpunktprogramm 1648 "Software for Exascale Computing" (SPPEXA) der Deutschen Forschungsgemeinschaft (DFG) unterstützt wird. Mit einer massiv parallelen Multigrid-Methode, die auf dem Paradigma der hierarchischen hybriden Gitter (HHG) basiert und im Open-Source-Framework Hybrid Tetrahedral Grids (HyTeG) implementiert ist, sind Berechnungen mit einer beispiellosen Auflösung des Erdmantels möglich. Die Rechengitter unterteilen den gesamten Mantel in Domänen mit einem Volumen von etwa 1 km3 (vergleichen Sie dies mit dem Volumen des Mantels von etwa 9,06 x 1012 km3). Infolgedessen wird bei jedem Zeitschritt einer Simulation ein enorm großes System mit über einer Billion (1012) Freiheitsgraden gelöst. Dies zeigt, warum die Mantelkonvektion als sogenanntes Grand-Challenge-Problem angesehen wird. Der Erfolg des TerraNeo-Projekts basiert auf einer langfristigen Zusammenarbeit zwischen den Gruppen Geophysik (LMU München), Numerische Mathematik (Prof. Barbara Wohlmuth, TU München) und Systemsimulation (Prof. Ulrich Rüde, FAU Erlangen-Nürnberg).

Rechnerinfrastruktur

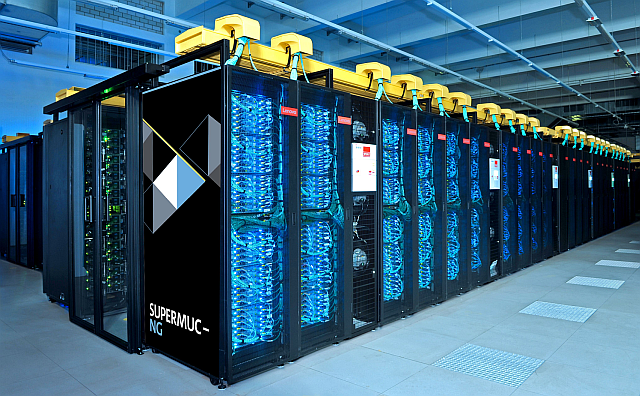

Um Software zu testen und routinemäßig geophysikalische Simulationen im mittleren Maßstab durchzuführen, betreibt die GeoComputing-Gruppe eine hervorragende Rechnerinfrastruktur. Im Zentrum steht hierbei der Münchner Tektonische Hochleistungssimulator (TETHYS). Daher kann ein Großteil dieses "Capacity Computing" betriebsintern durchgeführt werden. Für das "Capability Computing", d. h. für äußerst anspruchsvolle Simulationen, erhalten wir vom Leibniz-Rechenzentrum (LRZ) Zugang zu High-End-Supercomputing-Einrichtungen, insbesondere zu seinem derzeitigem Flaggschiff-Supercomputer SuperMUC-NG. Insgesamt stellt dies sicher, dass der wissenschaftliche Fortschritt in unserer Gruppe durch weltweit führende Fachkenntnis in der Entwicklung und Anwendung von Rechenressourcen unterstützt wird.